approfondimenti

OPINIONI

Al di là del Faust e dell’Hype. Appunti su Intelligenza Artificiale e dintorni – prima parte

A volte osannata come tecnologia rivoluzionaria, altre volte accompagnata da dubbi e paure, l’intelligenza artificiale è stata negli ultimi mesi al centro del dibattito, purtroppo spesso inquinato da mitologie turbocapitaliste o da incomprensioni sulle sue effettive potenzialità. Partendo dallo stato della ricerca, passando per le conseguenze nel mondo del lavoro, nei rapporti geopolitici e nell’immaginario comune, proviamo a delineare un quadro realistico sul ruolo di questa tecnologia

«Ma se nel mondo antico la macchina può essere ancora un simbolo dell’unità con la natura, o il prodotto di una ingegnosità fuori dal comune (come gli automi semoventi di Erone alessandrino), con l’arrivo della civiltà industriale e della modernità quella lacerazione fra uomo e natura, che già era espressa nel mito ma conservava una speranza di ricomporsi, è ormai insanabile», Antonio Caronia, Robot tra sogno e lavoro, 1991.

«Da questo punto di vista, la conoscenza si può descrivere come un organismo vivente […] E mentre vive, vive delle e nelle interpretazioni degli attori che ci interagiscono: che siano le persone che usano questa conoscenza per la loro vita o per farne altra, o che siano le entità computazionali che raccolgono questa conoscenza per qualche motivo, che sia il renderla accessibile in qualche modo da un motore di ricerca, o che sia per tentare di elaborarla con i processi dell’intelligenza artificiale», Salvatore Iaconesi, La spirale della conoscenza, 2020.

Nella sua pubblicazione Futuredays – A Nineteeth century vision of the year 2000, lo scrittore di fantascienza Isaac Asimov riportava nel 1986 una serie di 25 vignette risalenti alla fine del secolo precedente e pubblicate nel 1910, En l’an 2000, nelle quali l’illustratore francese Villemard rappresentava le previsioni e le fantasie dell’epoca sulla tecnologia e le sue applicazioni da lì a 100 anni. Nelle varie cartoline si vedono mezzi di trasporto futuristici e macchine di vario tipo capaci di sostituire il lavoro umano e manuale. A colpire sono principalmente due cose: una ovviamente è l’evidente accezione utopica e positiva della presenza di macchine che prendono il posto dell’essere umano nelle mansioni quotidiane, l’altra è la rappresentazione dei dispositivi fedele alla struttura meccanica del ruolo che devono sostituire. Così, ad esempio, un attrezzo per tagliare i capelli dispone di braccia e mani meccaniche con cui poter afferrare forbici e di un pettine, un utensile domestico automatico per pulire i pavimenti è costituito da un supporto su ruote che brandisce scopa e paletta, mentre invece per trasferire la conoscenza nella testa degli alunni una scuola dispone di una macchina che letteralmente ingerisce libri convertendoli e invia le nozioni ai fanciulli tramite cavi collegati alle loro teste.

D’altronde, in molti casi, la scienza ha provato a ottenere tecnologie capaci di simulare le facoltà umane tentando di riprodurre fedelmente le strutture che ce le consentono, ma più la facoltà interessata riguarda la sfera cognitiva, più si rischia che questo approccio porti su una falsa pista, oltre che creare confusione e incomprensioni nell’uso di queste tecnologie. Quando diciamo che una macchina – che sia una Olivetti Studio 44, un Mac o uno smartphone – sta scrivendo, di certo non pensiamo che abbia mani penna e taccuino, così come le macchine volanti non necessitano di ali. L’analogia tra lo scrivere umano e quello macchinico, quindi, raggiunge un certo livello di profondità, il cui limite è noto a chiunque.

Nel momento in cui però diciamo che una macchina pensa, o addirittura lo fa grazie a reti neurali e neuroni artificiali, ecco che la confusione aumenta, e non siamo più in grado di capire esattamente cosa significhi che pensa, quanto il suo pensare sia simile al pensare umano, o quanto può spingersi in là nel simulare il nostro pensare.

Il termine Intelligenza Artificiale comprende in realtà una gamma vastissima di tecniche e metodi. Prodotti come Midjourney, ChatGPT e simili hanno fatto conoscere al grande pubblico i cosiddetti “modelli generativi”, suscitando giustamente un enorme dibattito e ha mostrato in modo ancora in divenire l’impatto di queste tecnologie in tutta la sfera sociale. Proverò qui a fare intanto chiarezza sulla natura e la struttura di questi strumenti e analizzare brevemente il ruolo che stanno assumendo in un mondo in costante accelerazione.

Cosa può un corpus? Pappagalli stocastici e dove trovarli

Nel loro celebre paper On the Dangers of Stochastic Parrots: Can Language Models Be Too Big?, un gruppo di ricercatrici statunitensi lanciavano l’allarme sui rischi e le criticità nell’utilizzo dei cosiddetti Large Language Models (LLMs), i modelli linguistici come GPT e loro derivati. Come giustamente puntualizzano, queste tecnologie non sono capaci di comprendere il testo, ma riproducono a cascata una serie di parole a partire da quelle precedenti, secondo una certa struttura e coerenza. Sono, per usare l’analogia del paper, dei pappagalli stocastici, che assegnano una certa probabilità ai termini da scrivere. Fare questa precisazione è utile per ridurre l’hype associato a queste tecnologie, quindi per evitare fraintendimenti del loro utilizzo al grande pubblico. Inoltre in questa interpretazione si può indicare alla ricerca linee guida utili da seguire.

Quindi arriviamo alla domanda: cosa può e cosa non può fare ChatGPT? In questi mesi tante persone hanno provato a testarl_, studiarl_ e sperimentare le sue capacità.Le specifiche tecniche di addestramento di ChatGPT ora non sono dominio pubblico, ma dobbiamo pensare a un modello linguistico come a un un meccanismo per comporre frasi, dove la struttura del testo è appresa, ma i riferimenti precisi sbiadiscono.

Lo scrittore di fantascienza Ted Chiang ha scritto nel febbraio di quest’anno su “The New Yorker” uno degli articoli tra i più belli usciti sul tema AI: ChatGPT Is a Blurry JPEG of the Web. Chiang inizia raccontando come nel 2013 una ditta tedesca di fotocopiatrici si fosse accorta che una loro macchina quando copiava una planimetria con sopra dei valori di metratura (come 14.13, 21.11, 17.42), nella copia finale inseriva sempre lo stesso numero (14.13). Si accorsero che il fatto era dovuto al metodo di compressione che, per risparmiare memoria, associava tutti i numeri allo stesso simbolo per poi ripeterli dove fossero presenti. La fotocopia era una replica sfocata dell’originale. Lo stesso vale per ChatGPT: una copia sfocata dell’intero web. Far passare un LLM come sostituto di un motore di ricerca (come proposto da Microsoft con Bing e da Google con Bard) è sbagliato e pericoloso, perché non è la ricerca di riferimenti il compito a cui è addestrato. Certo, esistono anche servizi che, oltre alla risposta testuale, forniscono i link utilizzati per costruire il responso, ma a quel punto tanto vale utilizzare un motore di ricerca. Su cosa allora va forte un modello linguistico? Su ciò che riguarda specificatamente il linguaggio: traduzioni, riassunti e rephrase. Queste sono le attività su cui è addestrato, anche se in questi casi può ovviamente mostrare ribaltamenti di senso in casi particolari.

C’è un altro fatto che mi ha incuriosito in questi mesi: persone che non hanno una formazione informatica, sono rimaste estremamente sorprese nel vedere le capacità di ChatGPT di produrre codici come algoritmi per svolgere una data operazione o per produrre siti web. Personalmente, tra le varie funzionalità del prodotto, è quella che mi ha stupito meno: a un umano scrivere codice potrà sembrare un’operazione complessa perché richiede competenze specifiche, ma un codice che esegue una certa operazione è quasi sempre scritto nello stesso modo e il web è pieno di queste scritture. È del resto noto che esistono già da tempo forum dove si condividono codici per specifiche operazioni tra utenti. Insomma, scrivere codici è una delle attività più pappagallose che esistono. Certo, questo vale per task semplici e infatti è facile accorgersi che, se ChatGPT produce codici più complessi, spesso contengono piccoli errori che rendono comunque fondamentale un lavoro di controllo umano.

Un altro elemento fondamentale della questione è che, se ChatGPT esiste, è perché ha potuto ergersi su una quantità di informazione esorbitante raccolta e costruita da ognun_ di noi sul web (oltre al lavoro di eserciti sottopagati di tecnici), rendendola accessibile tramite un’interfaccia. Esiste quindi grazie a un lavoro collettivo, di rete, distribuito.

Con un po’ di ironia ma neanche troppo, mi verrebbe da dire che l’intelligenza artificiale esisteva già ed è nata il 6 agosto 1991, quando si è deciso di creare un’infrastruttura per raccogliere e contenere negli anni a venire la più grande raccolta di sapere umano. In confronto a questo balzo, ChatGPT (e LLMs in generale) non è che un piccolo tassello aggiunto.

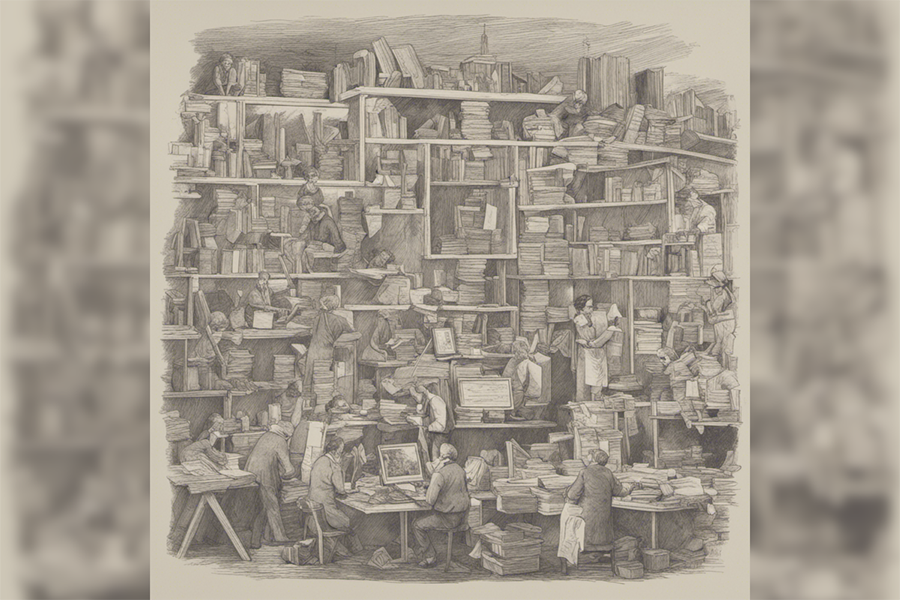

Immagine generata con DreamStudio con descrizione “un mondo senza lavoro”

Lavoro, copyright e tutto il vecchio che non muore

Con l’avvento di ChatGPT & Co. sono arrivati anche dubbi e timori sull’impatto futuro di queste tecnologie nella vita pubblica. Stando allo studio del World Economic Forum, The Future of Jobs Report 2020, l’Intelligenza Artificiale sostituirà 85 milioni di posti di lavoro nel mondo entro il 2025 ma ne creerà circa 97 milioni di nuovi. Ora ci sarebbe da intendere quali specifiche tecnologie intendiamo per intelligenza artificiale. Per quanto riguarda ancora i LLMS, per capire cosa sta e cosa potrà succedere basta riprendere il discorso relativo a cosa queste tecnologie possono e non possono fare. Sicuramente ChatGPT è uno strumento che riduce drasticamente un compito di traduzione, soprattutto se questa non richiede particolari attenzioni stilistiche e già ora probabilmente starà riducendo la forza lavoro richiesta a una redazione. Al tempo stesso però, anche questo task non sarà completamente sostituibile, perché occorrerà sempre una figura umana che controlli la correttezza del risultato o che fornisca la sua consulenza nel caso di specifiche scelte di traduzione.

Ancora, GPT potrebbe essere utile nella redazione di una testata di notizie spazzatura, dove il compito dei dipendenti è prendere testi da agenzie di stampa e rifrasare un po’ il contenuto per poter pubblicare così 10 articoli all’ora.

Insomma, sicuramente ChatGPT sarà in grado di far risparmiare tempo in caso di lavori ripetitivi e non raffinati che abbiano a che fare, appunto, con la manipolazione del linguaggio. Lo scenario che sembra configurarsi è quello definito come “human in the loop”, ovvero processo in cui una figura umana è presente in quanto supervisore delle attività di un IA.

Più i requisiti di conoscenze della professione aumentano, come nel caso della programmazione, più la figura di controllo sarà centrale e la posizione lavorativa sarà meno a rischio. Inoltre, il processo di produzione di ChatGPT coinvolge, oltre a controllori con particolari qualifiche, anche l’esercito di lavoratori poco qualificati che in Kenya, Uganda e India vengono sfruttati a 1,50 euro l’ora per etichettare discorso di odio, espressioni di violenza sessuale e altro materiale esplicito per “correggere la macchina”.

Un’altra grossa questione molto dibattuta negli ultimi mesi riguarda l’utilizzo di materiale reperibile online per l’addestramento di algoritmi machine learning e quindi la regolamentazione dei rapporti, economici e non solo, tra chi ha prodotto quel materiale e i proprietari dell’algoritmo. Artisti, programmatori e creatori di contenuti di vario tipo in questi mesi si sono espressi, contro l’utilizzo indebito delle loro opere dalle IA. Per quanto sicuramente queste azioni rappresentino richieste di tutela di forme di lavoro messe a rischio, credo che qualunque battaglia per la difesa o un ritorno della retribuzione basata sull’autorialità oltre che di retroguardia sia già persa davanti all’evidenza dei meccanismi della produzione del sapere.

Con l’avvento del digitale, quindi la virtualizzazione di un prodotto del lavoro svincolato da uno specifico supporto, era chiaro che l’attribuzione autoriale andava verso la sua impossibilità. Anche i tentativi riformistici legati alla galassia open source e Creative Commons pongono molti limiti: per quanto si possa mettere un bollino “No Uso Commerciale” su una repository di Github, una volta che un’idea di sviluppo software o di algoritmo è circolante, e quindi può essere re-implementata, in quello o in altro linguaggio, la paternità è svanita e solo a occhi chiusi non possiamo vedere come il mondo aziendale e delle corporation abbia in questi anni sfruttato la vasta conoscenza open source come terreno di estrazione gratuito.

Le IA sono solo un passo ulteriore in questa direzione: i dati possono essere ristrutturati, riformulati, usati come addestramento per la costruzione di un prodotto. Le lotte e le richieste di tutela del lavoro cognitivo sono fondamentali, ma assumono valore strategico se considerate in un percorso verso una politica di reddito universale svincolato dal lavoro e lo scenario delle nuove tecnologie offre a questo percorso un’opportunità di spazio nel dibattito pubblico da non doversi lasciare scappare.

Inoltre, dall’esperienza della GKN di Campi Bisenzio e da nuovi progetti nell’ambiente tech arriva una suggestione che potrebbe essere interessante iniziare a discutere e capire, tra lavoratrici e lavoratori dell’informazione e dello sviluppo tecnologico, cioè se e come sia possibile, oltre alla riconquista di diritti sul lavoro, anche a riprogettare la produzione e, perché no, anche ridefinire gli scopi e le direzioni di sviluppo dell’intelligenza artificiale a partire dal basso, in una prospettiva di welfare, servizi utili alla comunità e conversione ecologica.

Immagine di copertina generata con DreamStudio con descrizione “pappagallo stocastico”